Früher gab es unter Mac OS X die Möglichkeit, die Restlaufzeit der Batterie anzeigen zu lassen. Das war zwar nicht immer präzise, da die Restzeit-Berechnung anhand der aktuellen Systemlast erfolgte. Trotzdem war die Funktion jederzeit praktisch. Seit einigen MacOS-Versionen gibt es die Funktion nicht mehr. Doch es gibt eine einfache Möglichkeit, sie wiederherzustellen.

coconutBattery installieren

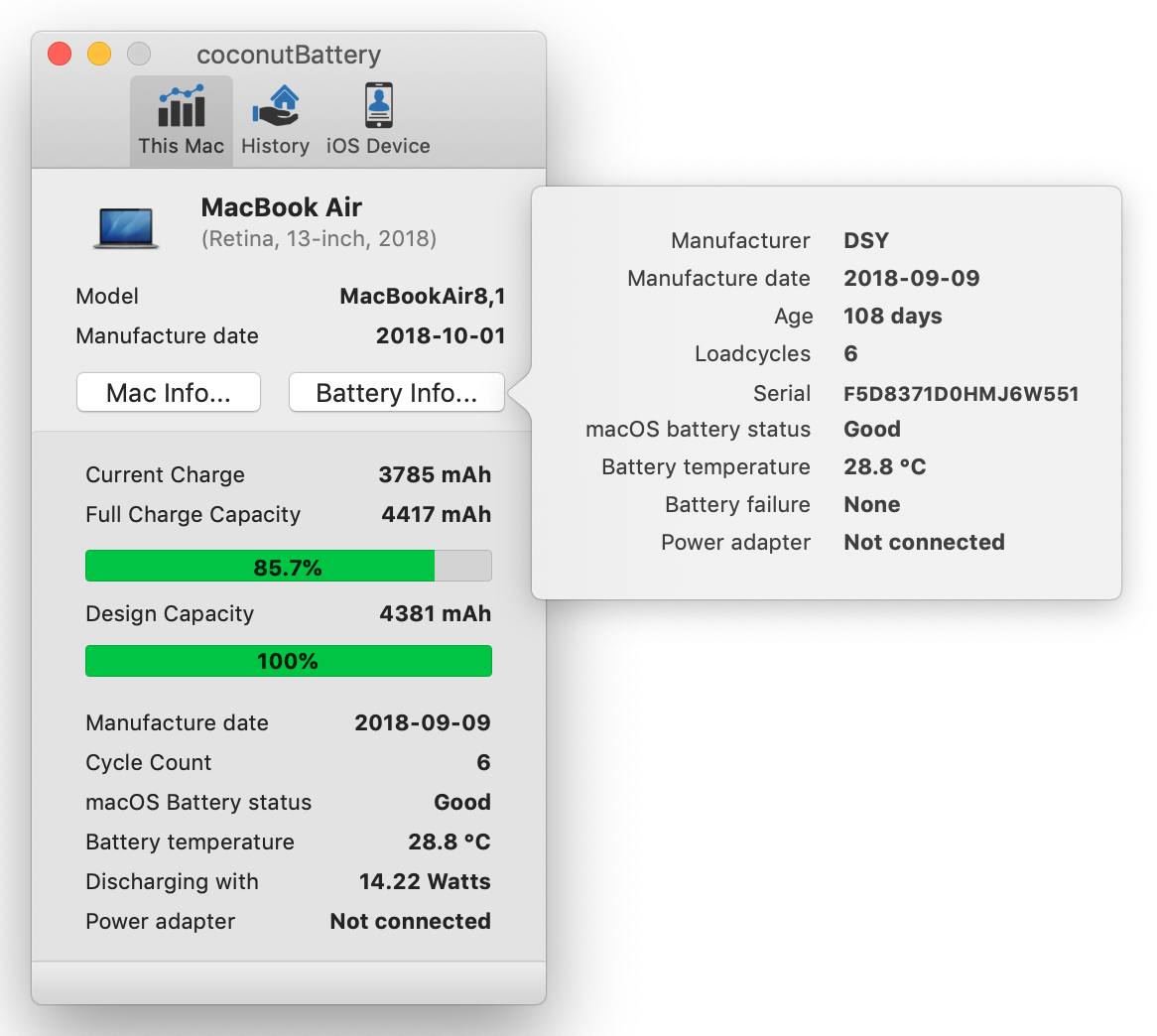

Alles, was Ihr dazu benötigt, ist ein kleines Extra-Tool namens CoconutBattery: Ladet es zunächst von der Website des Entwicklers herunter, entpackt die ZIP-Datei und verschiebt die App in den Programme-Ordner Eures MacBooks. Anschließend könnt Ihr dass Programm starten: Es zeigt Euch interessante Informationen über den Status Eures Macbook-Akkus an.

Macbook-Restlaufzeit mit coconutBattery anzeigen

Das Tool coconutBattery hilft Euch aber auch dabei, die Restlaufzeit des Akkus zu ermitteln:

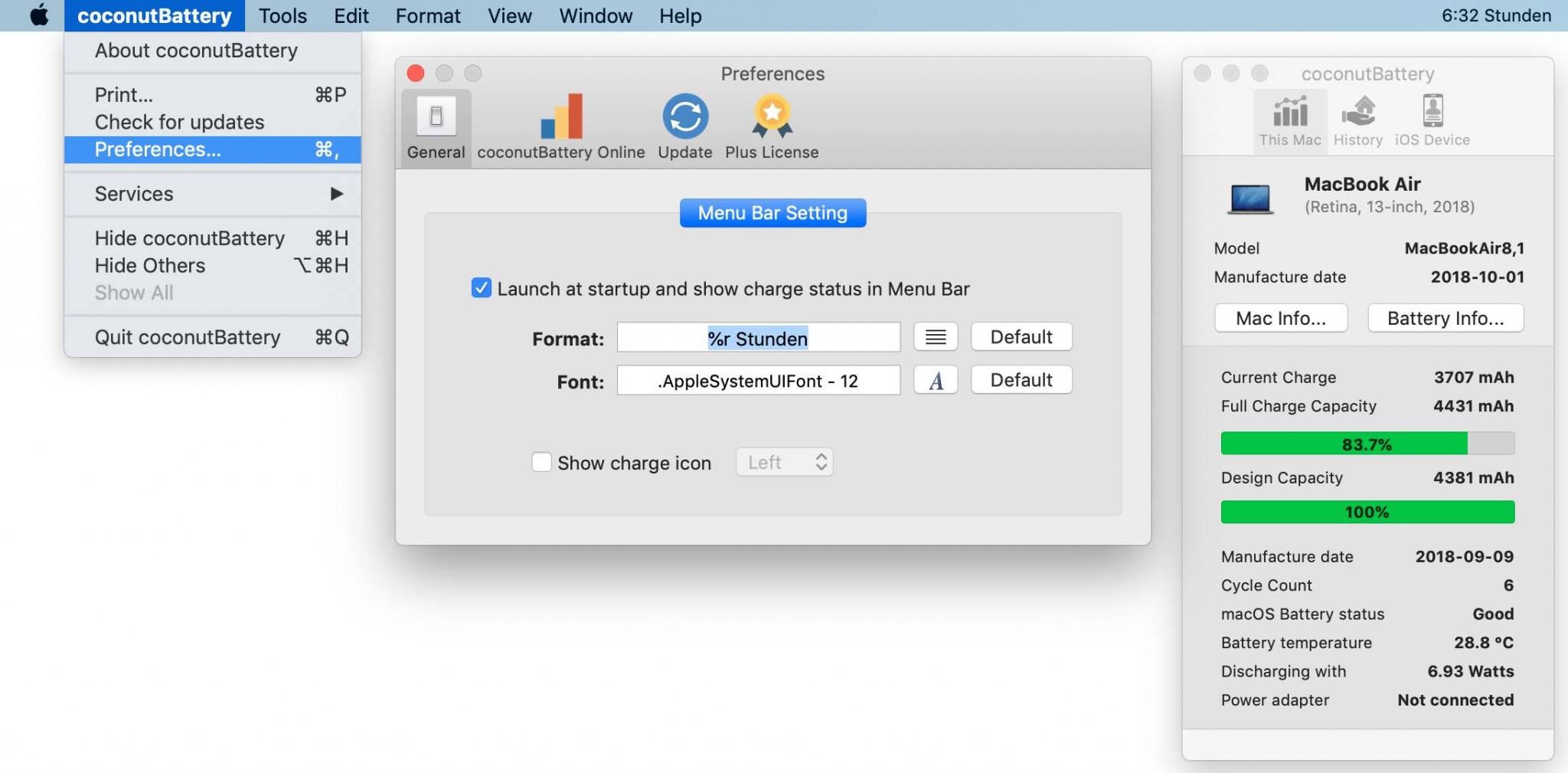

- Öffnet zunächst die Einstellungen des Programms, indem Ihr in der Menüzeile coconutBattery -> Preferences auswählt.

- Klickt hier auf den Reiter "General" und setzt einen Haken bei "Lauch at startup and show charge status in menu bar".

- Gebt unter "Format" %r ein, gefolgt von einer weiteren Information, etwa "Stunden" oder "h".

- Schließt die Einstellungen anschließend wieder. Die Akku-Restlaufzeit Eures MacBooks wird jetzt dauerhaft in der Menüzeile angezeigt. Die Anzeige wird laufend anhand der aktuellen Nutzung aktualisiert.

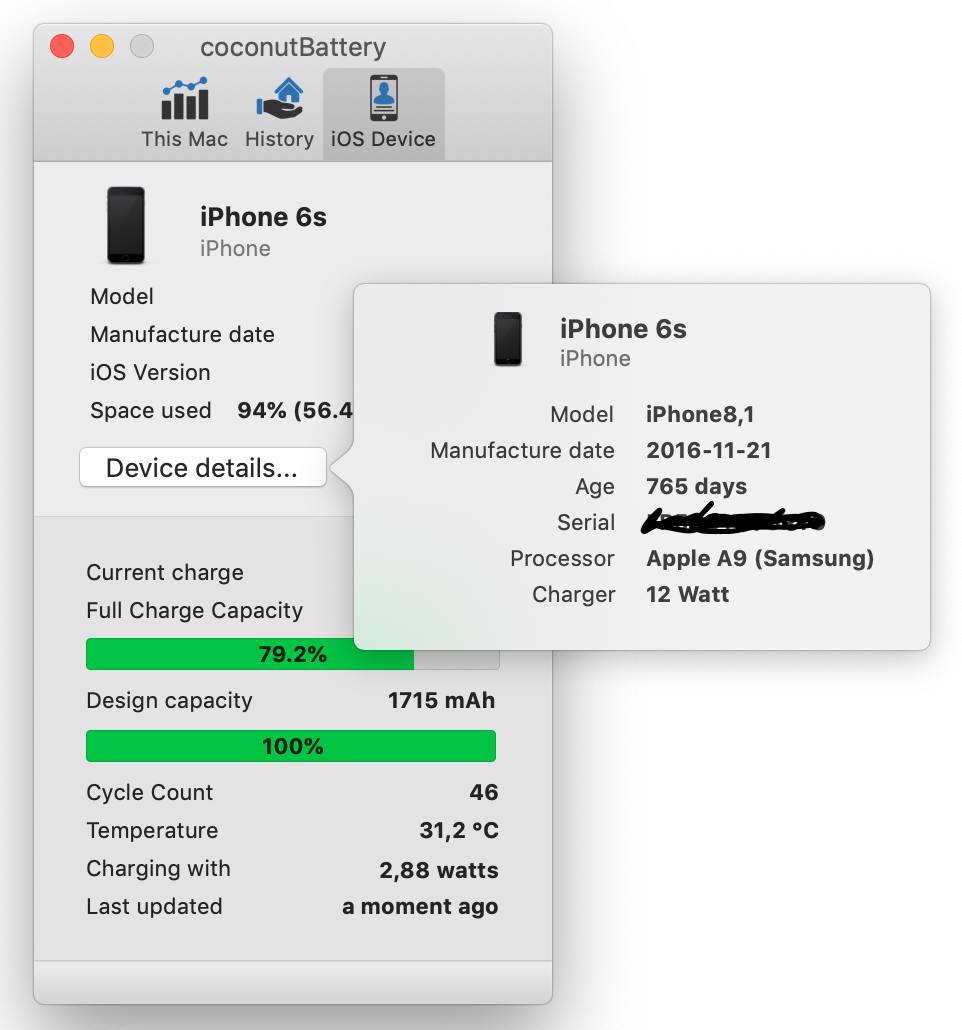

coconutBattery hilft auch bei der Akku-Überprüfung von iPhone und iPad

Übrigens: coconutBattery kann nicht nur den Akku-Zustand von MacBooks prüfen: Im Programmfenster gibt es einen Reiter "iOS Devices". Um diesen nutzen zu können, müsst Ihr Euer iPhone oder iPad mit dem USB-Ladekabel mit dem Macbook verbinden und auf den Reset-Knopf drücken. CoconutBattery zeigt nun Informationen über die Akku-Gesundheit Eures iOS-Geräts an. Das ist hilfreich, wenn sich die Frage stellt, ob der Akku kaputt ist – oder ob Ihr einfach nicht genug Energie spart.

hallo, nicht ganz so komfortabel aber für die Restanzeige kann man auch einfach Bordmittel von MacOs verwenden: die Aktivitätsanzeige. Unter dem Reiter „Energie“ erscheint die zu erwartende verbleibende Zeit im Batteriebetrieb. Grüße

Ah, das hatte ich noch gar nicht gesehen. Danke für den ergänzenden Tipp! :)